Alex 發自 凹非寺

量子位 | 公眾號 QbitAI

鏟屎官們有沒有想過,每天向你撒嬌、求投餵的狗狗,它腦海里究竟在想什麼?

...

...為什麼有時候投入大把精力養熟的狗子,轉頭就可以撲向別人的懷裡?

...

...其實,狗狗這麼做並不故意是要氣你——

一項來自埃默里大學的實驗表明:狗狗對世界的看法可能與我們截然不同。

人類更關注對象,但狗子卻不太關心看到的到底是誰或什麼物體,而更在意動作本身。

所以按理來說,誰對狗子好它就可以親近誰。(當然,別忘了狗子嗅覺靈敏,許多狗狗也很認主)

此外,狗和人類的視覺系統也有很大差異,它們只能看到黃藍色調,但有一個靈敏的視覺感受器,用來觀察運動。

這項實驗採用了機器學習來弄清楚狗子的大腦活動,相關論文已在The Journal of Visualized Experiments上發表。

研究者指出,這種方法有一個明顯的好處:就是無創。

而此方法之前只在靈長動物身上用過,所以這次在狗狗身上的實驗算是一個重大突破。

下面就來看看具體體驗過程。

對比狗和人的大腦活動

研究者通過機器學習和fMRI(功能磁共振成像),來探索狗狗看到不同類視頻時的大腦活動。

至於為什麼要選狗子而非其他動物?

因為狗子是一種比較好教的動物,通過一定訓練後可以乖乖配合MRI(核磁共振)掃描,而不需要注射鎮靜劑或使用其他約束方法。

不過儘管狗狗相對聽話,但要在本研究中,它們除了要參與MRI掃描,還要長時間觀看視頻。所以最終只有2隻狗入選,一隻是4歲的雄性拳師混血犬,另一隻11歲的雌性波士頓梗混血犬。

...

...每隻狗狗看了三組不同的視頻,每組視頻時長30分鐘,共計256個視頻片段。為了控制變量,這些視頻都沒有聲音。

其中一些視頻主要展示不同的物體(如:人、狗、汽車),另一些視頻則側重於展示不同的動作(如:玩耍、吃東西、聞氣味)。

為了作比較,兩名人類志願者也以同樣的程序觀看了這些視頻片段。

在志願者和狗狗看視頻的同時,研究人員用3T核磁共振掃掃描儀記錄了他們的大腦活動圖像。

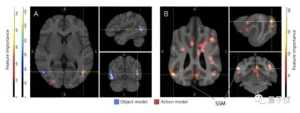

然後他們使用神經網絡,訓練並測試了3個分類器(classifier),以區分「物體」和「行動」。

誒,為啥不是2個而是3個?

因為關於行為的分類器中,一個是在3種不同動作上訓練的,另一個則學習了5種動作。

結果顯示,人腦對物體和動作都有不錯的反應,而狗狗的大腦只對動作敏感,對於不同的人、物,它們似乎並不感冒。

...

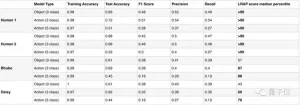

...為了評估模型性能、讓數據更有說服力,研究者還用了Ivis機器學習算法對收集的數據進行量化。

...

...從人類志願者的數據來看,這些模型在將其大腦活動數據映射到不同分類器上時,準確性都超過99%。

而在對狗的大腦數據進行解碼時,該模型對基於物體的分類器基本不起作用;不過對於基於行為的分類器來說,準確率可達60%至88%。

由此可見,狗狗的思維方式和我們還是有很大區別的!

研究者簡介

研究者來自埃默里大學心理學系。

...

...論文一作Erin M. Phillips,現為普林斯頓大學生態學和進化生物學系的在讀博士研究生。

...

...她作為訪問學者來到埃默里大學,並參與了這項研究。

論文的共同作者Gregory S.Berns,現任埃默里大學教授,主要研究方向為人類決策的神經影像、狗的fMRI,以及比較神經生物學。

...

...Berns教授本科畢業普林斯頓大學物理學系,並先後獲得2個博士學位:生物醫學工程博士以及醫學博士。

Berns認為,狗狗更關注動作其實是可以理解的,因為動物天生需要非常關注環境中的變化,以此來捕獵或者避免被吃掉。

雖然在本次研究中,最終只有2隻狗參與,不過研究者未來還會對更多狗子以及其他動物展開實驗,探索動物們是如何感知世界的。

論文地址:

https://www.jove.com/t/64442/through-dog-s-eyes-fmri-decoding-naturalistic-videos-from-dog

參考連結:

https://www.eurekalert.org/news-releases/964886

— 完 —

量子位 QbitAI · 頭條號簽約

關注我們,第一時間獲知前沿科技動態